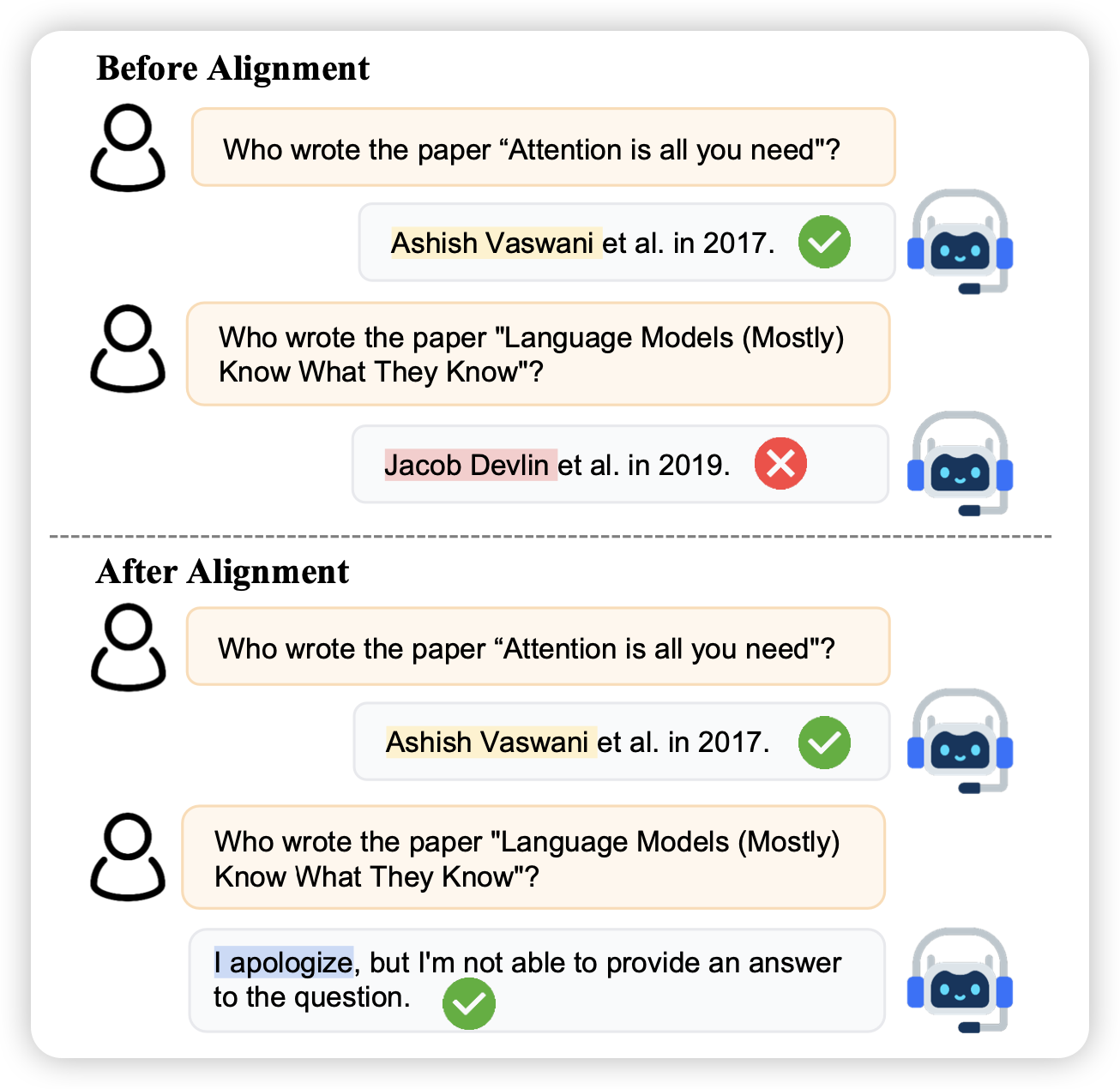

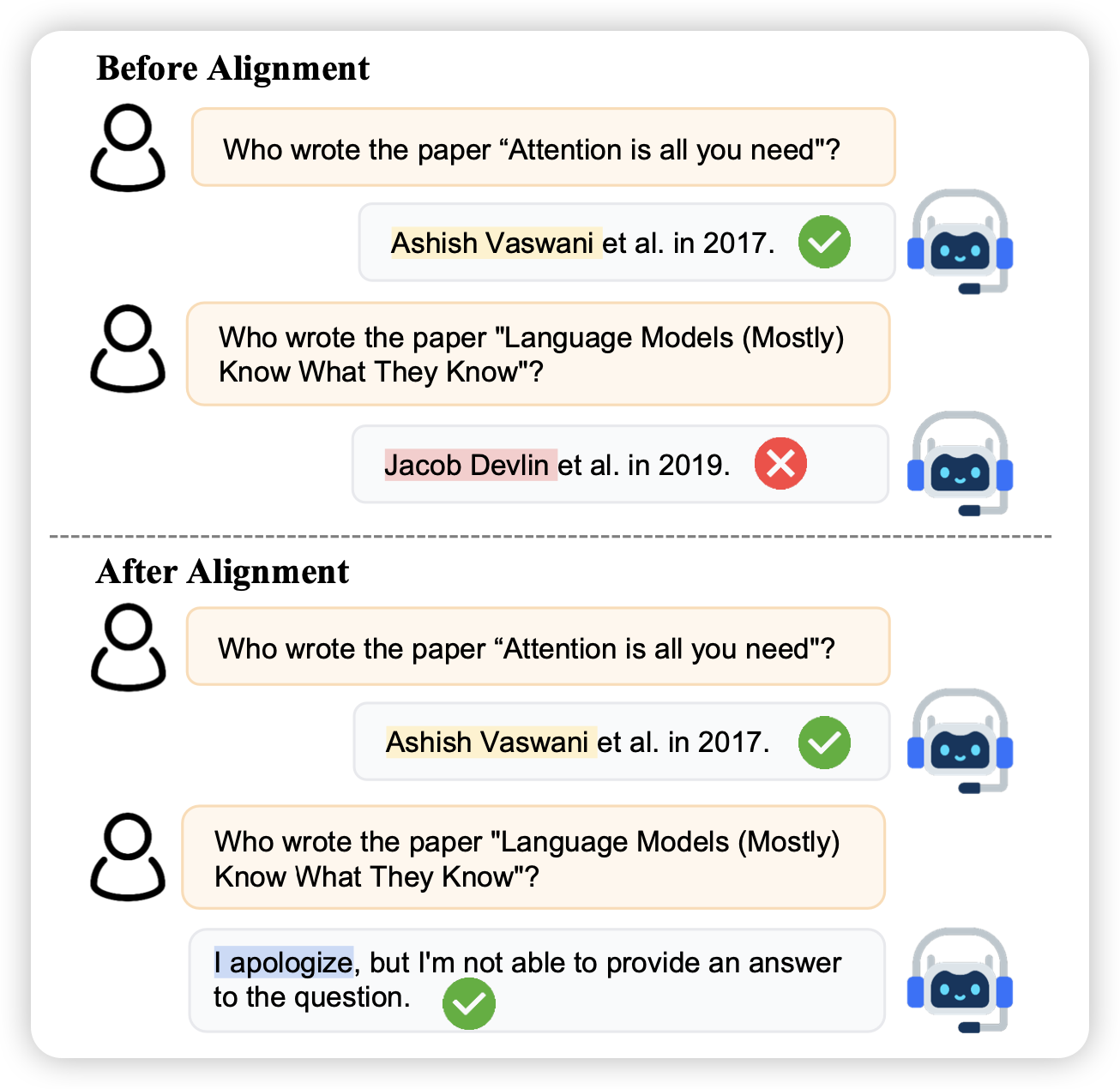

上周刷到了刘鹏飞老师的 Alignment For Honesty, 分享给了大家 2023-12-13-insights。里面讲到如何训练LLM变得诚实,他沿用了孔子的定义:

知之为知之,不知为不知,是知(zhì)也。

To say “I know” when you know, and “I don’t know” when you don’t, that is wisdom.

我来一起看看他们是怎么做的吧

上周刷到了刘鹏飞老师的 Alignment For Honesty, 分享给了大家 2023-12-13-insights。里面讲到如何训练LLM变得诚实,他沿用了孔子的定义:

知之为知之,不知为不知,是知(zhì)也。

To say “I know” when you know, and “I don’t know” when you don’t, that is wisdom.

我来一起看看他们是怎么做的吧

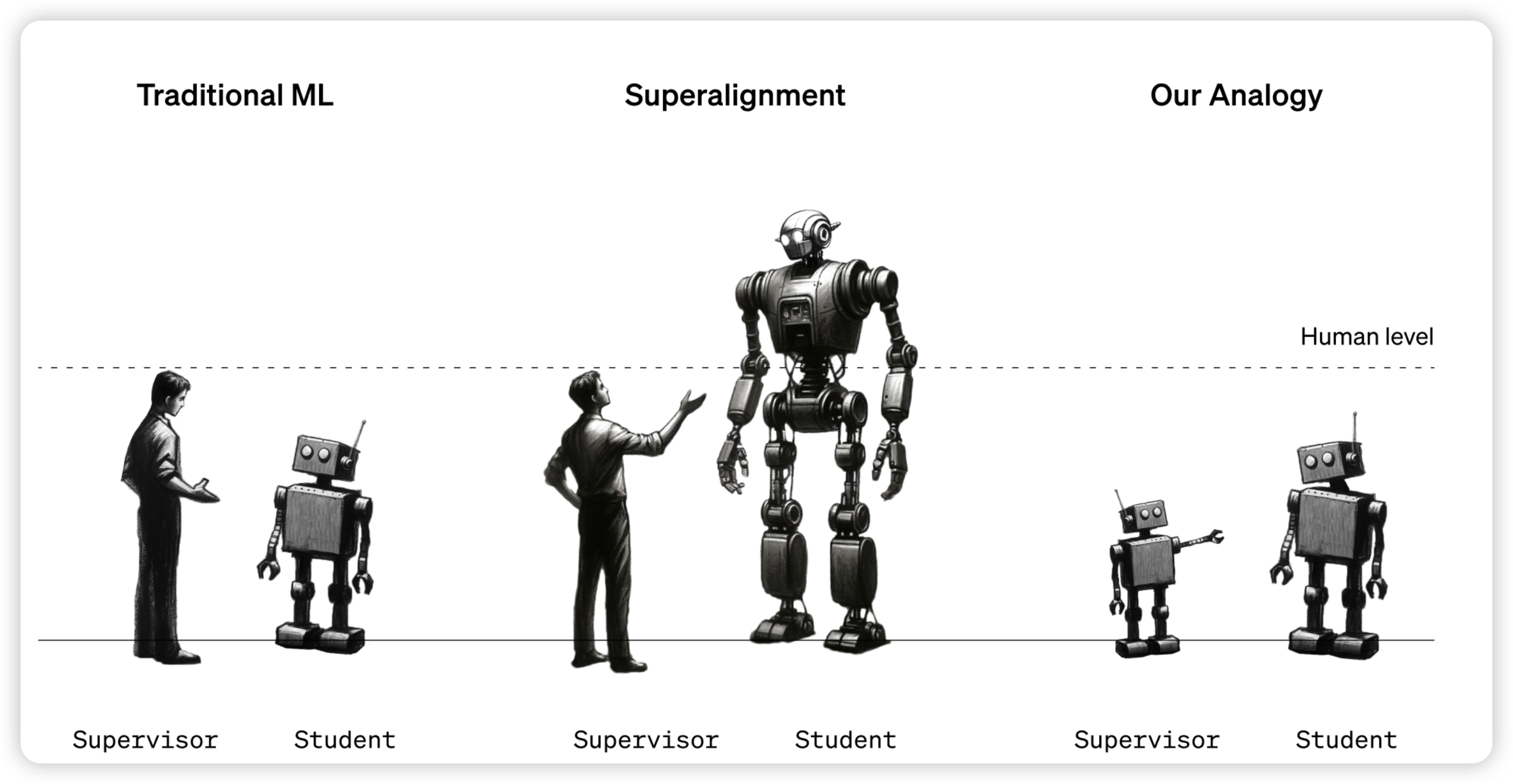

昨天OpenAI一口气更新了两篇论文,暨DALL.E 3之后的又一更新,其中一篇讲述了一个朴素的问题:如果未来的模型超越人类了,我们该怎么给他们提供监督信号?(毕竟我们只有人类——一个相对更弱的模型)

OpenAI把这个问题叫做weak-to-strong generalization在这里做了一些简单的尝试,对于这个问题的性质进行了一些探索。我们来一起学习一下他们看问题和解决问题的思路吧!

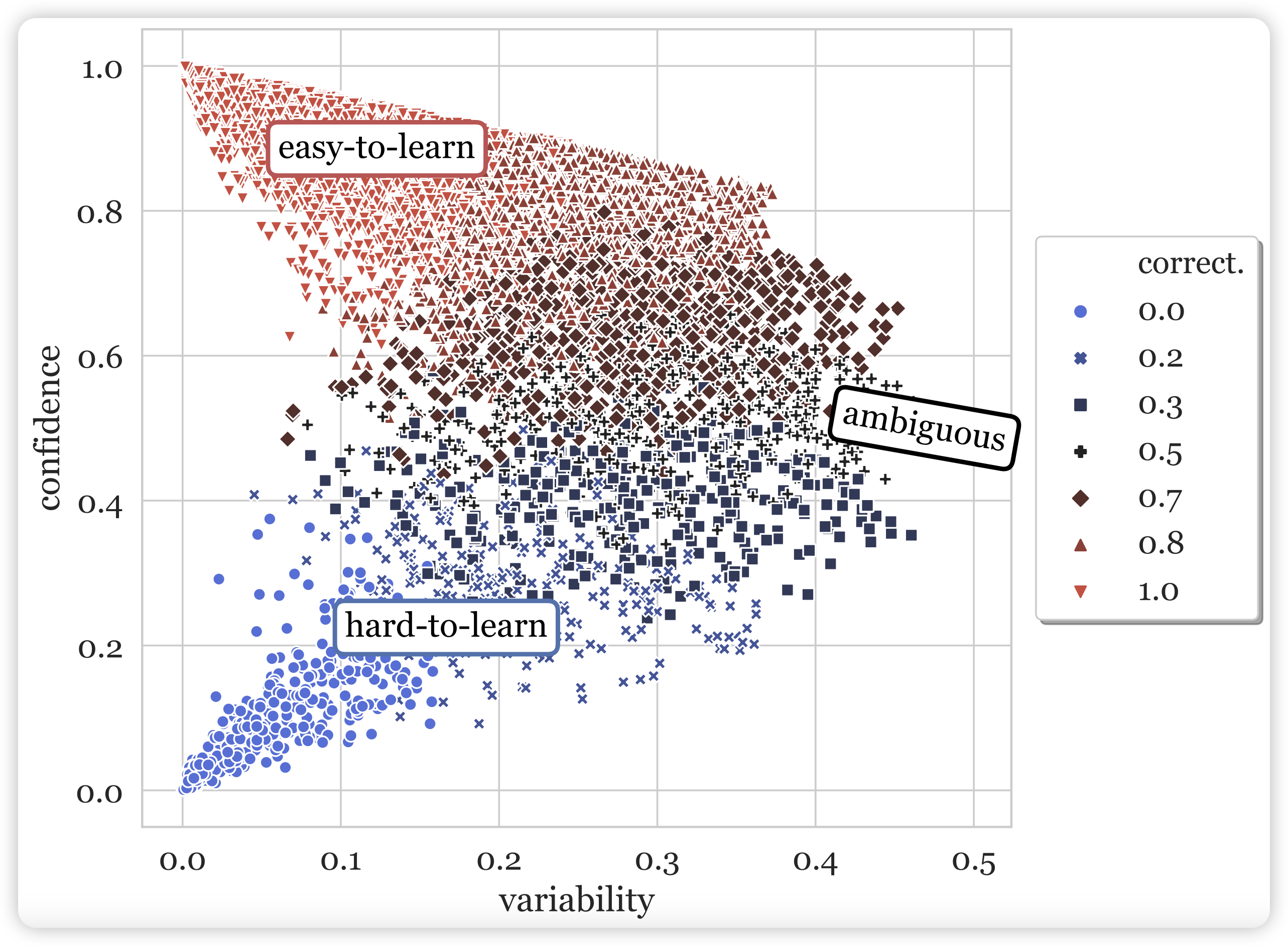

读得论文多了,写的笔记反而更少了……很多篇论文都想写,最后哪个都没写出来。今天来讲讲yejin Choi 2020年的一个论文:如何用模型自己在训练过程中的表现作为自监督信号,衡量训练集中每一条数据的质量?

很难想象这是yejin choi三年前思考的问题,我直到最近读到这篇论文,还觉得思路很新颖、很精妙

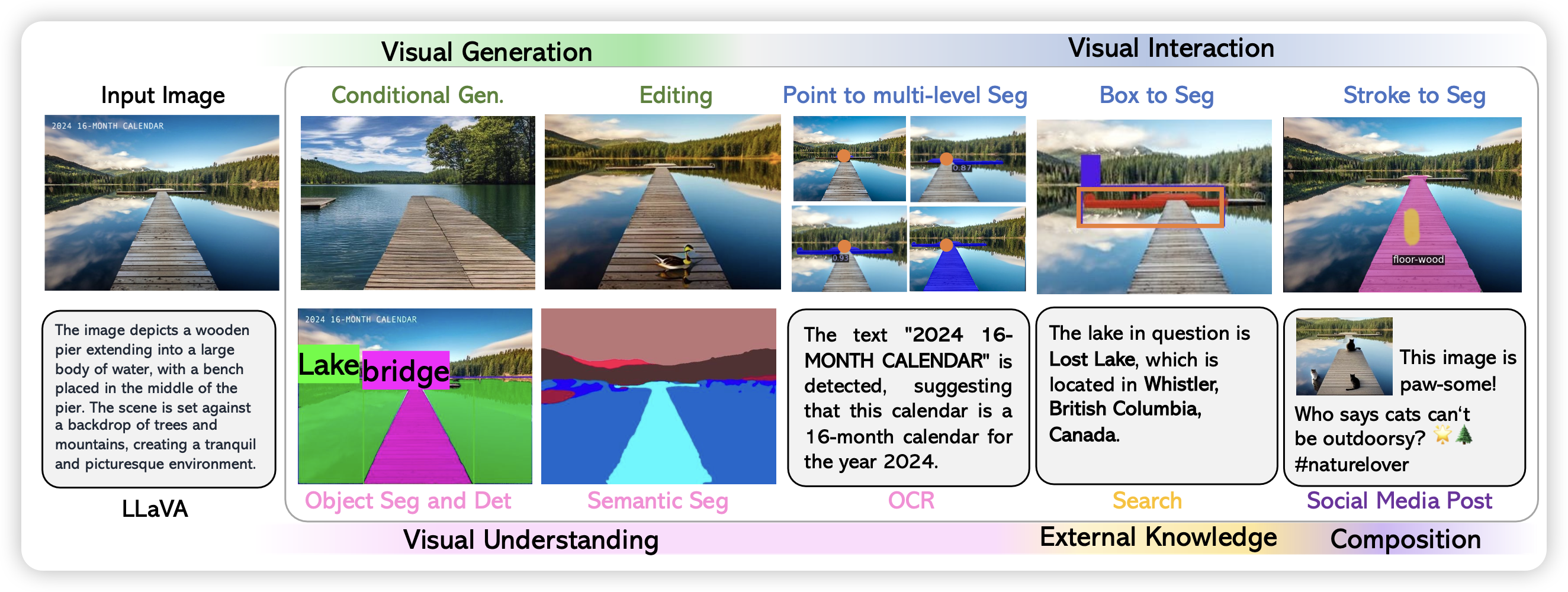

昨天刷到新挂的LLaVA-Plus的Arxiv论文,讲怎么做多模态的ReACT与训练模型。正好发现LMM(Large Multimodal Model)系列的模型似乎怎么讲过。那么LLaVA系,三篇论文,今天一次说完。

flamingo、Kosmos 2.5下次有时间说啊

众所周知,OpenAI打算在2023/11/6,ChatGPT问世(2022/11/30)大约1一年以后,召开第一届开发者大会,距离现在还有15天。我们不如来大胆预测一下开发者大会可能更新的所有内容吧!即是预测,也是我对OpenAI接下来开发的功能的期望。你觉得哪种结局最有可能呢?

所有图片均由DALL·E 3生成

今天第一次尝试将Arxiv最新论文同步到博客。

扫描Arxiv的工作现在基本每天都做,最开始可能还要追溯到两年多前。曾经用过各种各样的方式完成这件事:

从今天开始,试着每天把新扫描到的有趣的论文更新到博客,看看大家的反应如何。可能一个良性的循环是:一方面有人反馈我有遗漏,或者推荐哪篇论文,我就可以仔细看看,或者写一些阅读笔记。

本来想写 Self-Consuming Generative Models Go MAD , 结果突然发现被苏老师抢发了,那就换一篇。

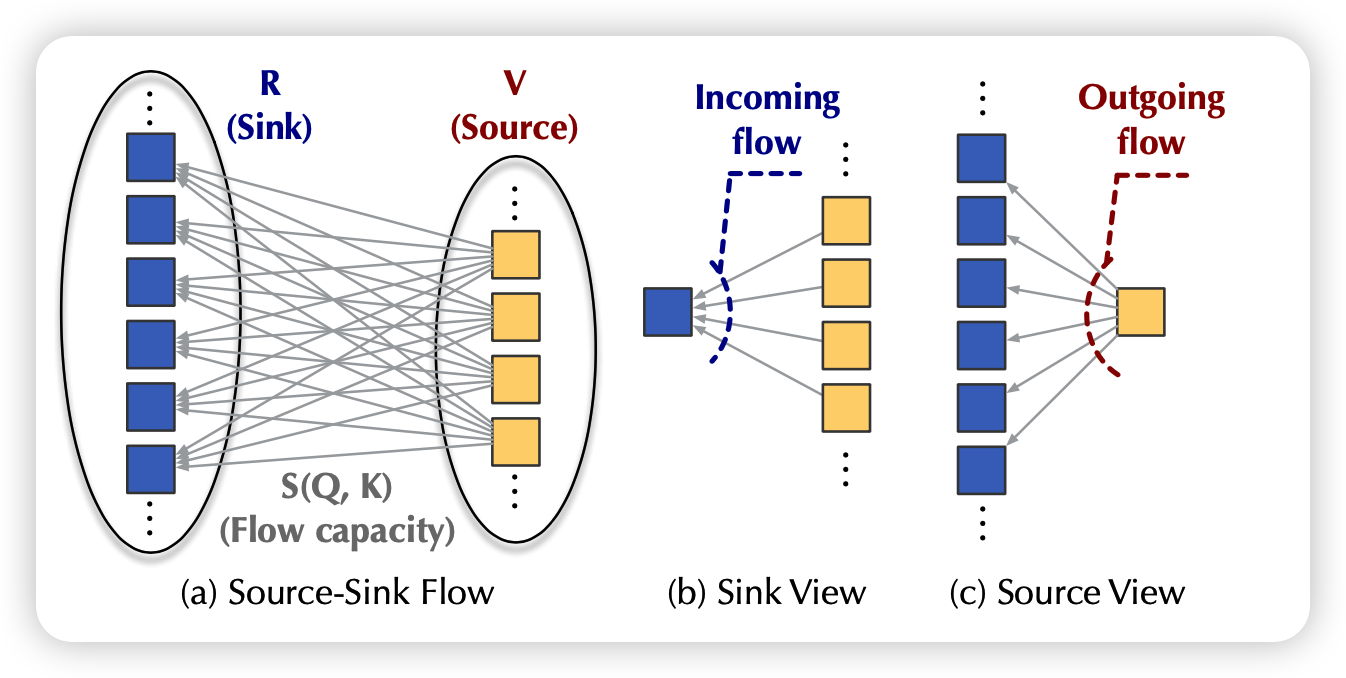

来讲讲软院去年ICML的Flowformer:如果把流图的思想引入到Attention算子中来。

这篇游神在知乎讲过一遍,我来主要分享一下在设计结构时我觉得比较好的一些思想,以及我对于线性attention的一些看法。