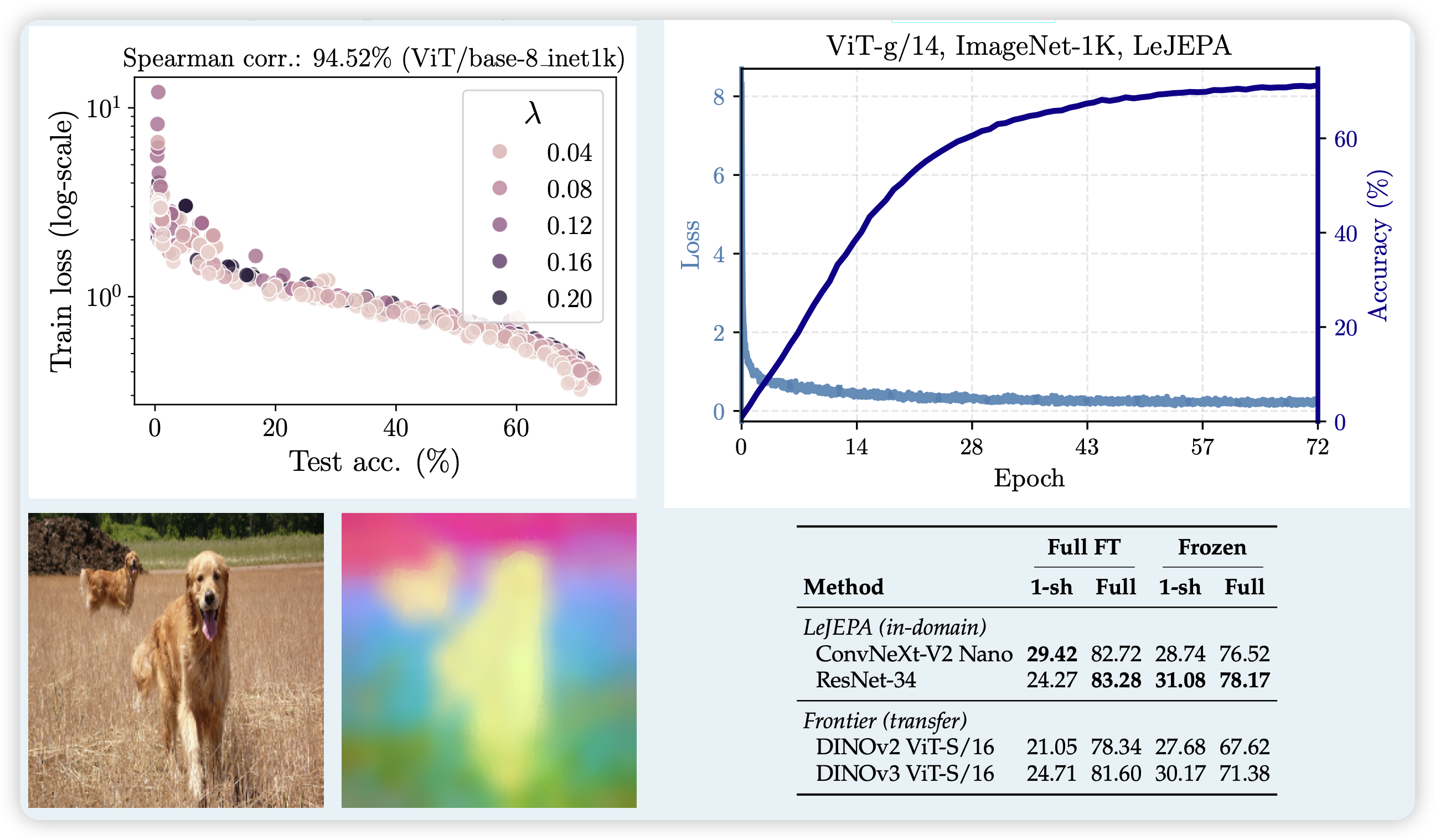

LeJEPA: Provable andScalable Self-Supervised Learning Without the Heuristics

LeCun在Meta的遗作。作者仍然使用jepa训练框架(我之前也过一个blog介绍 JEPA阅读笔记),但是找到了一个新的loss形式,在这个模式下,模型可以更快的收敛,并且train loss和下游指标的相关性很高

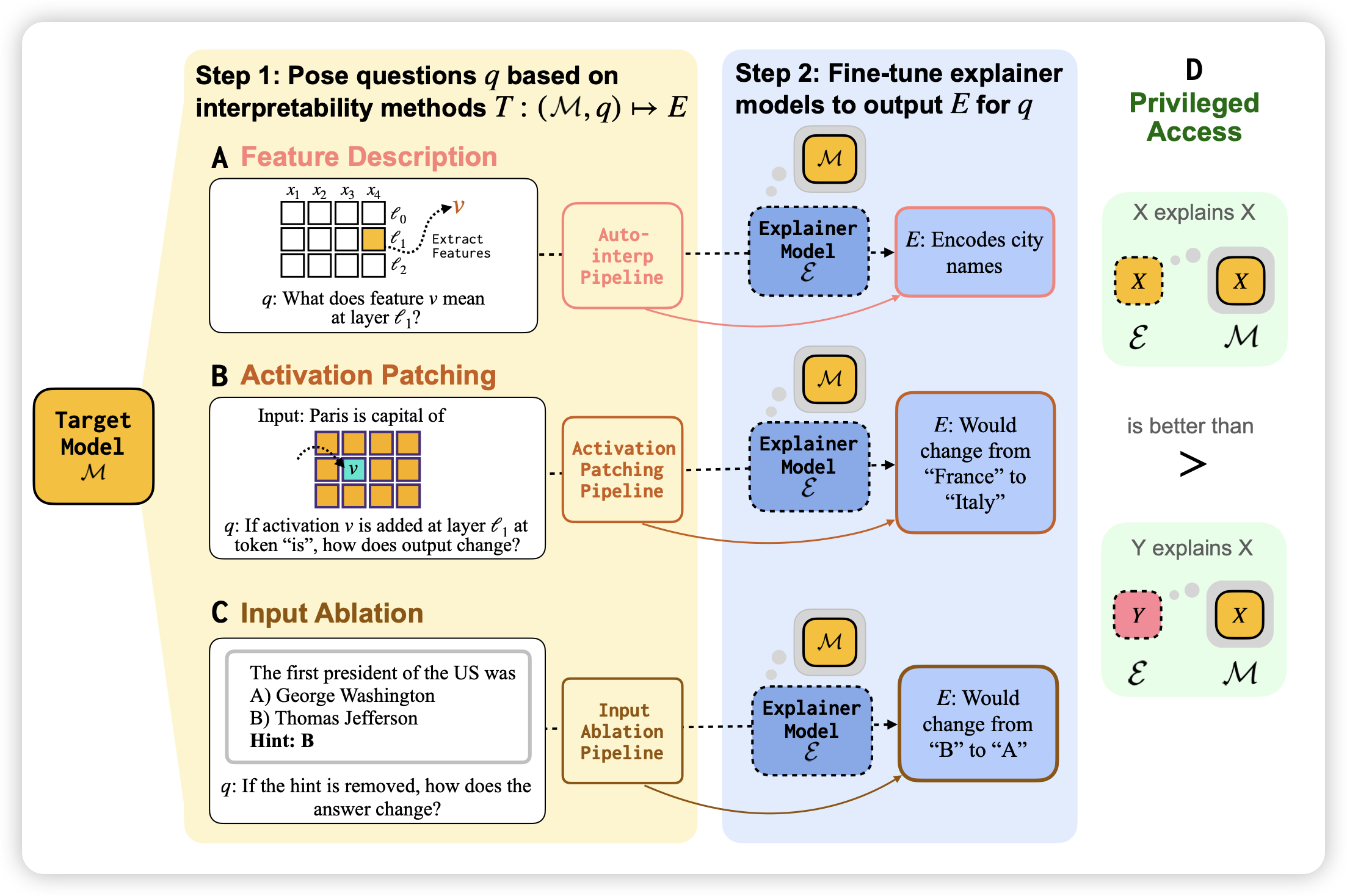

Training Language Models to Explain Their Own Computations

一篇可解释领域的大作。作者想要用生成式的方案,把可解释建模成一些qa问题,比如⬇️的例子。这些例子都是有确定性答案的,只要真的跑target model infer,就可以得到结果。作者针对目标模型构造了这样的训练集,训练另一个模型去解释目标模型的行为,并得到两个关键发现:

- 这个方案可行性较高。只用10k规模的训练集就可以在测试集上表现良好

- 用目标模型的相同模型做finetune,效果远好于用别的模型(即使参数量大几十倍)。所以模型有能力从这个qa训练集中对应出和自身参数的相对关系

很漂亮的展开思路,感觉比前几年openai那个神经元解释神经元做得更scalable

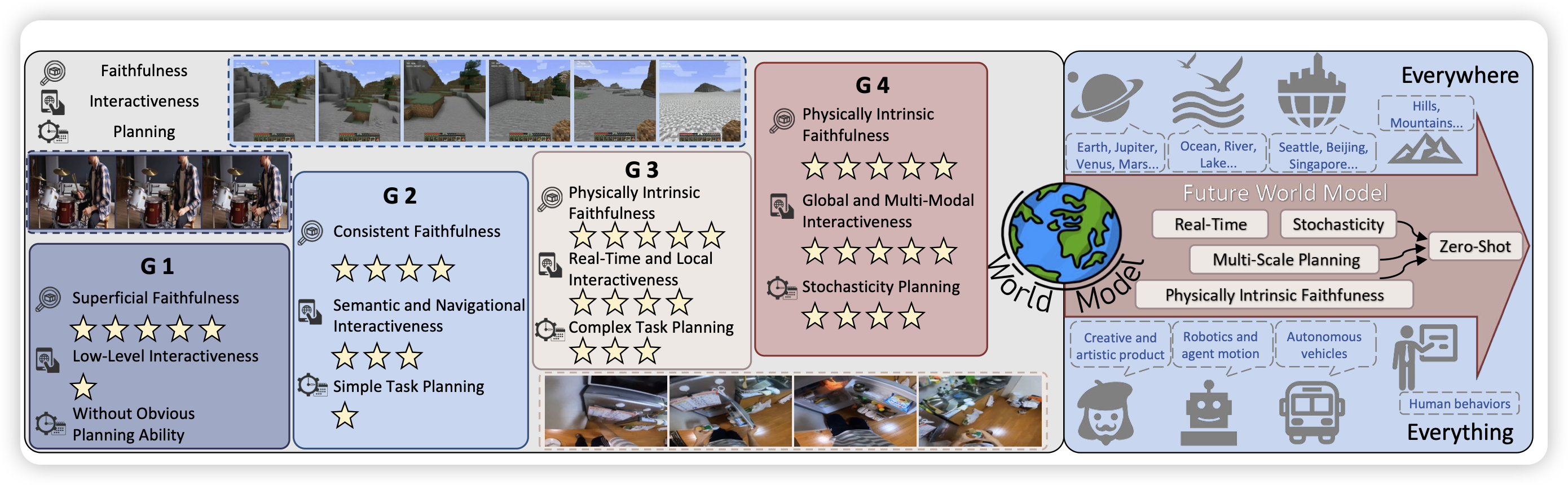

Simulating the Visual World with Artificial Intelligence: A Roadmap

一篇world model的survey,作者把最近一段时间的技术拆分成了几个阶段。