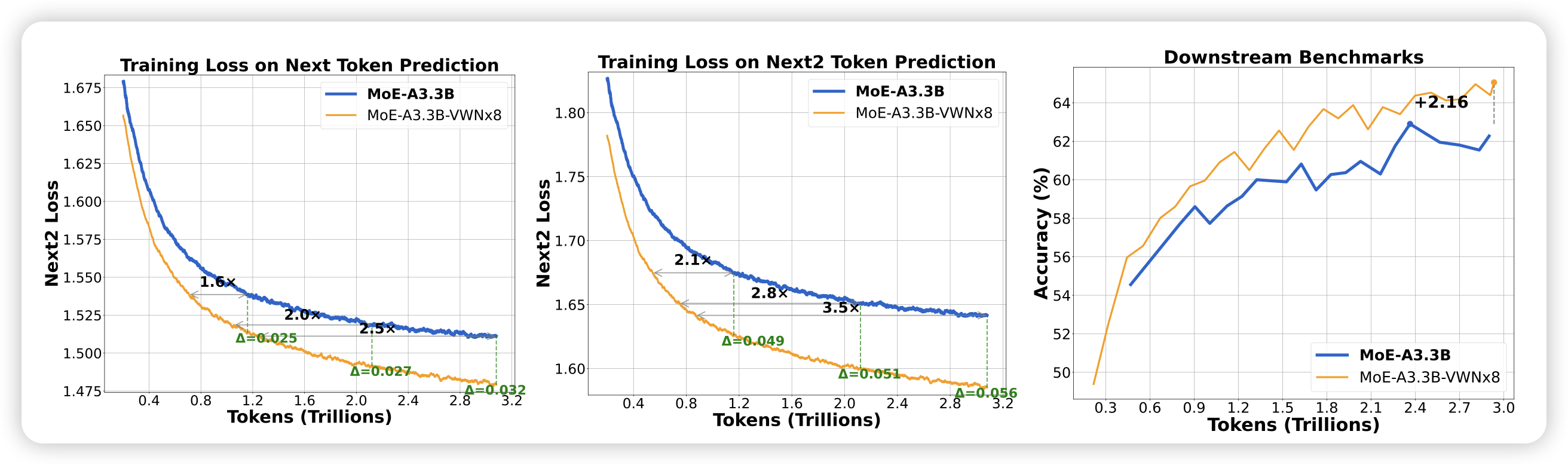

Virtual Width Networks

一篇模型结构的工作,作者讨论了一种叫做over-width的技巧。就是把word embedding的宽度搞得很大,然后在每个transformer block的入口投影成小维度,然后过一个比较窄的attention block,出来再投影到比较大,然后做残差链接。用这个方法,其实计算量增加不会很大的情况下,可以把模型参数量扩展到很大。

作者认为,模型有能力使用这些多出来的宽度去存储一些更深度、高维的信息,由此在与训练中获得更好的效果

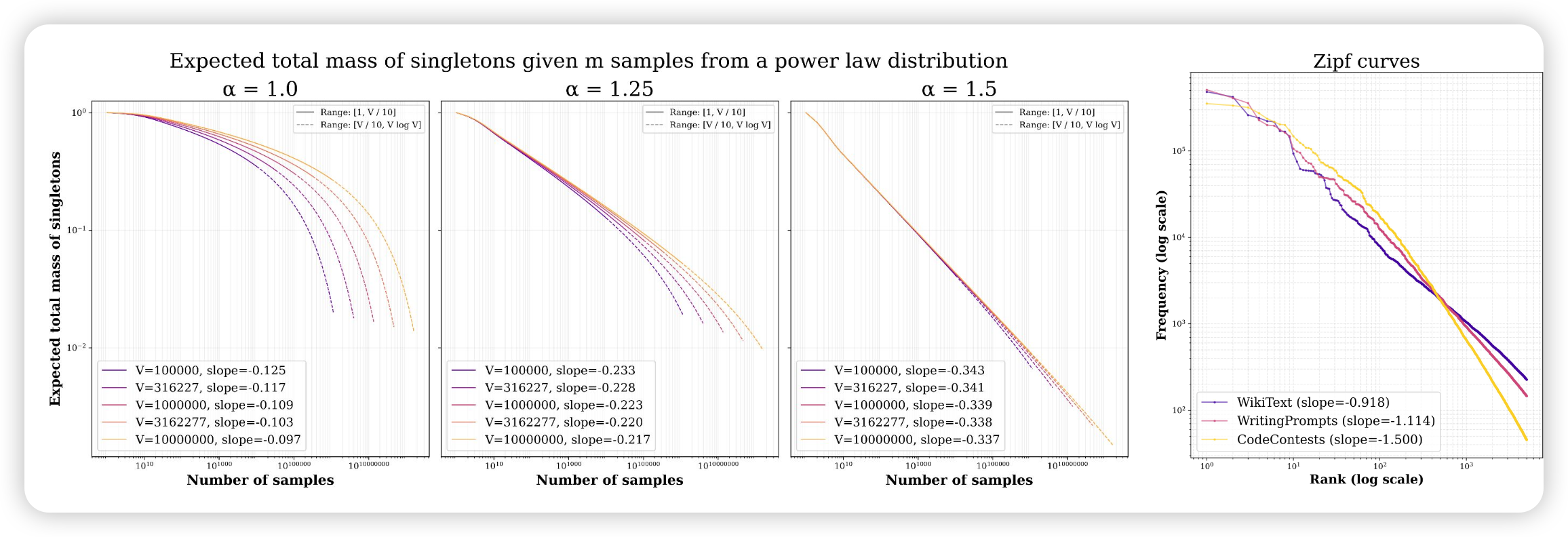

On the Entropy Calibration of Language Models

一篇比较理论的工作,作者分析了模型的gen entropy为什么总是会随着生成而上升,也就是说越生成越会混乱。正是因为有这个事实存在,所以应用中大家经常需要topk/topp采样,等于是强制破坏模型分布来解决entropy的问题。作者得出了两个结论:

- 越生成越混乱,似乎是一种固有属性。随着模型参数量增大,改善及其不明显

- 这种累积误差的积累程度,和场景关系很大。在code场景似乎不严重,但对于开放生成影响就非常明显

最后,作者实验性地提出了一种(工程上无法实现因为太慢了)的算法,可以比topk/topp这种“破坏式”算法更好保留多样性,但又能解决累积误差的办法。未来,也许可以有所突破

典型地percy liang式论文,逻辑严谨,自成一体